古いブラウザをご利用のためサイトが正常に動作しません。

最新のブラウザをダウンロードしてご利用くださいませ。

Google Chrome / Edge / FireFox / safari

お知らせ

2024.08.01

人のプレゼンテーションより、アニメーションのほうが○○!? 奈良先端科学技術大学院大学のAR研究者 藤本雄一郎先生に聞いてみた

2024年2月15日に行われた、アニメーションの記憶定着効果実験。採用担当者による10分間のプレゼンテーションと、約3分のアニメーションでは、「短期的な記憶効果」や分かりやすさは、人よりもアニメーションの方が効果的であることが分かった。

その実験にご協力いただいた、奈良先端科学技術大学院大学 助教の藤本雄一郎先生と、弊社代表の沢井啓秀が、実験を振り返って対談。また、ARなどの技術についても興味深いお話を伺った。

<調査概要>

*調査方法:対面調査

*調査人数・対象者:18歳~25歳の男女・29人

――まず、改めて藤本先生の研究をご説明していただいてもよろしいですか?

藤本雄一郎先生(以下、「藤本」):はい。拡張現実空間(AR)やバーチャルリアリティー(VR)を利用して、人がある作業をうまくできるようにサポート、もしくはトレーニングをする技術を提案しています。

具体的には、ARではメーカーが使う作業支援システムです。機器を組み立てることは、初心者には難しい。紙による作業書ではなく、工具の3Dや、ここを触ればいいという指示が空間に出てくれば、作業がしやすくなる。ただし、こういうシステムを作るのは、熟練のデベロッパーさんじゃないと難しいんです。なので、プログラミングの技術がない人でも、そういうコンテンツを作れるツールを開発しています。

沢井啓秀(以下、「沢井」):たとえば自動車メーカーさんなどの工員さん向けのマニュアルとかですか?

藤本:そうですね。OJT(On the Job Training:先輩や上司が後輩に知識や技術を教えること)が一番シナリオとしてはぴったりです。

沢井:ありがとうございます。では、そもそもの話なのですが、なぜ実験に協力してくださったんですか?

藤本:まず、加藤博一教授からお話がありました。記憶への定着へのデータをとりたいということでしたが、私の初期の研究が、ARと記憶についてだったんです。

今回の研究では、ARではなくアニメーションですが、記憶の効果を確かめるというデータについて、貢献できるところがあると思いました。

沢井:まったく畑違いということでもなかったんですね。

ARと記憶ということは、ARで勉強や学習に使えるコンテンツがあるということですか?

藤本:はい。たとえば、英単語を学習するとき。モノを見て、ARを通してその上に英単語が表示されていれば、「これがこの英単語か」と分かる。

単語帳やアプリといったものを使うと、これらは「意味記憶」になりますが、モノ自体を見て場所と関連付けて覚えると、「エピソード記憶」に近くなるのではないかと。

沢井:歴史の勉強なんかは特に、ストーリーとして覚えると分かりやすいとよく聞きます。英単語もそういった覚え方ができるということですか?

藤本:そうですね。

沢井:実際、ARを使ったときの記憶力のスコアはよかったんでしょうか?

藤本:はい。①ある物体の近くに英単語を表示させたとき、②常に同じ場所に英単語を表示させたとき、③まったく関係のない場所に英単語を表示したとき。この3つでは、近くに表示したときに最も記憶の定着がいいという結果が出ました。

沢井:そうなんですね。今回のアニメーションの実験では、どういう結果を予想されていましたか? 実際やってみてのご感想をお聞きしたいです。

藤本:人が発する情報量はとても多いですよね。声量やトーン、ジェスチャーだとか。

その影響も大きいと思っていたので、やってみないと分からないというのが正直ありました(笑)

アニメーション自体はよくできていると思いました。

沢井:私も、慣れていない方ならまだしも、慣れている人事担当の方だとどうなのかなと。やばいなとは思っていたんですけど(笑)

――結果は、アニメーションのほうが採用担当者によるプレゼンテーションよりも約22%も記憶が定着しやすいというものでした。意外でしたか?

藤本:そうですね、直観に反していたというか。どうしてこうなったのかなと。

結果論ですが、3つほどその理由が推測できます。

一つ目は、アニメーションは「文脈が統制されている」ということ。エピソード記憶の話が先ほど出ましたが、文脈があるほうが人は覚えやすい。アニメーションはそれが1分弱でまとまっています。

採用担当者の方のプレゼンテーションは、1枚1枚のスライド自体が離散的というか、別の話のように感じられることがあります。そうなると、どうしてもひとつなぎの話としては捉えにくい。

また、「大事な情報ですよ」という「シグナル」もありますよね。

沢井:効果音やポップアップなどの表現ですね?

藤本:そうです。それが2つ目。流れてくる情報のどこに注目するかは、文字の表示の仕方や効果音でシグナル化されているので、聞き手に伝わりやすかったのかなと思います。

3つ目は、「若年者は動画を観るのに慣れているから」。動画から情報を抽出することに長けていると感じました。

――「シグナル」に該当するものは生身の人でいうと「ジェスチャー」かと思いますが、それを効果的に使うのはかなり属人性が高いですね。

少し話が逸れるかもしれないのですが、最近、アニメーションを制作していて、「生身の人の声よりも、AIの声のほうがいい」というご意見をいただくことが増えてきたんです。途中まではAI音声で作り、内容が校了になったらプロの声優さんに差し替えを依頼するのですが、2パターン聴いたお客様が、AI音声のほうを支持する場合が多くなりました。

「棒読みちゃん」とか「ゆっくり実況」が出てきたとき……すみません、「ゆっくり実況」、ご存知ですか?

藤本:はい(笑)

――ありがとうございます(笑)。そういった機械音声が出始めたときと、現在のAI音声の評価はかなり違うと感じています。「生身の人間が関与しないこと」が、むしろ学習や記憶への働きかけを手伝うことがあるのではと思っています。

藤本:興味深い話ですね。奈良先端科学技術大学院大学で、バーチャルオープンキャンパス

を体験してもらう企画がありました。私は各研究室のアピール動画の取りまとめをしたんです。

私たちも同じように、AI音声で各説明を入れて制作した後、プロのナレーターに差し替えの音声を依頼しました。私の依頼の仕方が悪かったのもあるかもしれませんが、ナレーターさんの声は少し抑揚が強すぎる箇所がありました。研究室の情報に集中してほしいのに、その読み上げる熱量、抑揚に耳がいってしまう。それと同じようなことかなと。

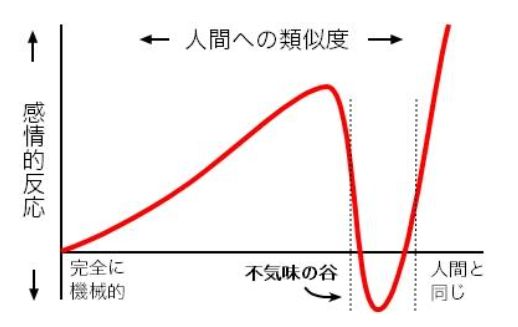

昔の機械音声と今の機械音声は、クオリティがまったく違うものになってきているというのもあると思います。「不気味の谷」ってご存知ですか?

簡単に言うと、「ロボットなどが人間らしくなるほど、親しみやすさも増すけれど、あるところで急に不気味になる」というものです。(図参照)。

なので、今どんどん機械音声は技術も向上しているし、心理的に受け入れられるようになってきている(図の右肩上がりのあたり)。必要な情報だけにフォーカスできるようになったのかなと。

――確かに今はInstagramやYoutubeの短い動画はほとんどがAI音声で、私ももう慣れてきました。

藤本:色々お話しましたが、全然専門ではないので、偉そうなことは言えないのですが(笑)

今後、綺麗な読み上げができるAIだけではなく、癖があるもの・ベテランの抑揚の付け方を完全に再現できるようなものが出てくる気がします。私はAIの研究者ではなくユーザーなので、ある種楽しみです。ARは不気味の谷の前段階なので、危機感はまだ薄いですね。

――そうなるとシンギュラリティというか、すごいことが起こりそうですね。

沢井:アニメーションの短期的な記憶効果についてだけではなく、とても興味深い話をお伺いできました。ありがとうございました。

藤本:ありがとうございました。